Datenschutzkonform mit KIs chatten

Datenschutzkonforme Dienste nutzen

Bei der Verwendung von Chatbots wie Bing, ChatGPT, Gemini usw. ist damit zu rechnen, dass die Nutzungsdaten von den Unternehmen oder von Dritten ausgewertet werden. Eine Möglichkeit dies zu umgehen, ist die Nutzung datenschutzkonformer Services, wie z.B. der von der GWDG (Gesellschaft für wissenschaftliche Datenverarbeitung mbH Göttingen) angebotene. Er erlaubt es mit unterschiedlichen KI Modellen zu interagieren. Hierbei werden von der GWDG strenge Datenschutzbestimmungen zugrunde gelegt. Der Service steht den Mitgliedern der Freien Universität Berlin kostenlos zur Verfügung (Federated Login -> FU Berlin).Ein eigenes Sprachmodell auf dem PC lokal installieren

In letzter Zeit ist es gelungen, Chatbots wie ChatGPT auf eine Größe zu bringen, die es erlaubt, ein "Großes Sprachmodell" (LLM, für "Large Language Model") lokal auf dem eigenen Rechner auszuführen. Das ist zum Beispiel mit Blick auf Datenschutzbedenken wichtig und spannend für alle, die ein solches Werkzeug nutzen wollen, ohne auf Online-Angebote von großen Technologieunternehmen zurückgreifen zu müssen. Klingt ein bisschen "nerdig", ist aber gar nicht so schwer.Eine gewisse Hürde stellt auch der Ressourcenbedarf auf dem Rechner dar. Es stehen Modelle unterschiedlicher Größe zur Verfügung, aber selbst der Download der kleinsten Modelle benötigt einige Gigabyte Festplattenplatz. Grundsätzlich ist dies eigentlich erstaunlich klein, wenn man bedenkt, dass LLMs mitunter einen beträchtlichen Anteil der Textdaten des gesamten Internets enthalten. Auch werden für die Ausführung mindestens 8 GB Arbeitsspeicher (besser mehr) benötigt und auch die benötigte Rechenleistung ist nicht unerheblich. Wie sie den Arbeitsspeicher Ihres eigenen Rechners und die Auslastung ihres Prozessors ("CPU") herausfinden, dass können Sie beispielsweise hier nachsehen. Eine aktuelle Grafikkarte wirkt sich meist deutlich positiv auf die Geschwindigkeit aus, da diese Rechenkerne (sog. "GPUs") mitbringt, die von dem Programm genutzt werden können.

Zwar bleiben die Möglichkeiten lokaler Sprachmodelle meist hinter denen kommerzieller Anbieter zurück, dafür hat man aber ein lokales Programm, das auch ohne Internet funktioniert, d.h. die Eingaben verlassen den Rechner nicht. So kann man die Möglichkeiten von LLMs risikolos selbst nutzen und ausprobieren, ohne sich Gedanken über die Preisgabe von Daten oder die Weiterverwendung durch Dritte machen zu müssen.

Im Folgenden stellen wir zwei Projekte vor, die es ermöglichen, große Sprachmodelle (LLMs) privat auf handelsüblichen Laptops und Desktop-PCs auszuführen: "GPT4All" und "Ollama". GPT4All bietet derzeit eine verbesserte Oberfläche und einen erweiterten Funktionsumfang, wie z.B. das Hochladen eigener Dokumente. Ollama erscheint in der aktuellen Version (Stand Sept. 2024) GPT4All etwas unterlegen. Während Ollama eher als eine "Graswurzelinitiative" erscheint, hat GPT4All bereits ein Preismodell für Unternehmen, - ist allerdings für Privatnutzer (noch) kostenlos. Eine Herausforderung bei der Vorstellung solcher Informatikprodukte ist, dass sie sich sehr schnell entwickeln. Gerade im Bereich "KI" kommen derzeit fast täglich Meldungen über neue Produktversionen. Daher wird an dieser Stelle bewusst kein Anspruch auf Aktualität und Vollständigkeit erhoben.

Eine einfache Möglichkeit bietet das Projekt GPT4All.

Möglichkeit 1 : GPT4All

In diesem Video wird die derzeit aktuelle Version 3.0 von "GPT4All" (September, 2024), einem kostenlosen und leistungsstarken KI-Chatbot, vorgestellt. GPT4All 3.0 bringt eine neu überarbeitete Benutzeroberfläche, Möglichkeiten zum Umgang mit lokalen Dokumenten und eine einfache Installation. Harald Frey zeigt in dem Video, wie man GPT4All installiert, wie man lokale Sprachmodelle einbindet, die allgemeinen Einstellungen vornimmt, mit den lokalen Sprachmodellen chattet, lokale Dateien hochlädt und schließlich auch wie man ChatGPT4 in GPT4All nutzt. Die Funktionen von GPT4All umfassen auch eine Verwaltung von lokalen Dokumenten, die in einer vektorbasierten Datenbank eingelesen werden. Die Dokumente werden dann im Kontext des "Chats" mit der KI berücksichtigt.Eine andere Möglichkeit, Open-Source-Sprachmodelle lokal auf dem eigenen Rechner auszuführen, bietet das Projekt Ollama.

Möglichkeit 2 : Ollama

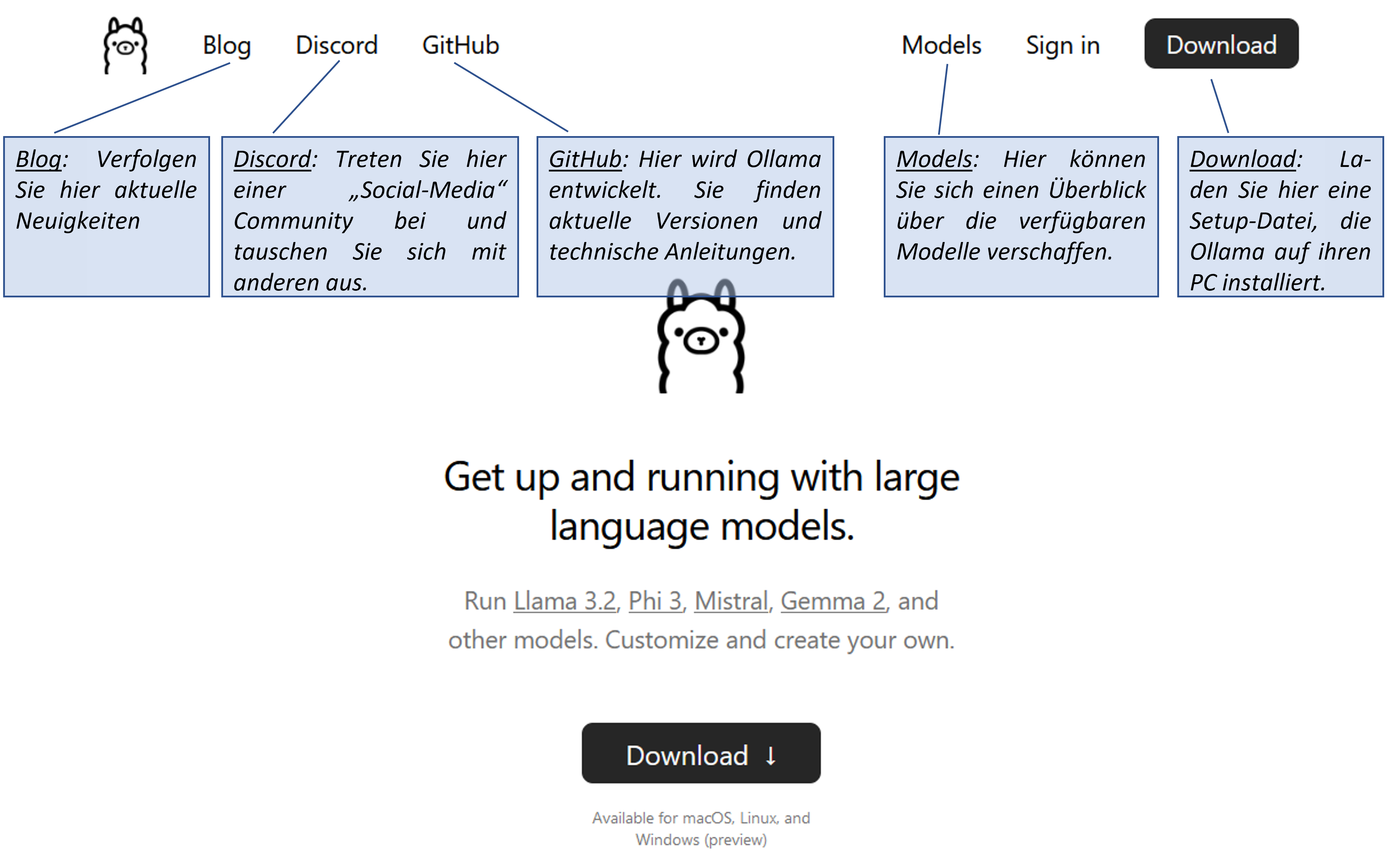

Auf der Startseite zeigt sich (Oktober, 2024) folgendes Bild:

Bild: Seite nach Aufruf von https://ollama.com/ (8.10.2024)

Schritt 1: "Ollama" herunterladen und installieren

Durch Klicken auf "Download" wird nach Angabe des Betriebssystems (macOS, Linux oder Windows) der Download des entsprechenden Installationsprogramms angestoßen. Das heruntergeladene Programm muss nun noch ausgeführt werden, um die Installation von Ollama zu starten.Schritt 2: Ollama starten

Zum Start benötigen Sie ein Fenster mit einer Eingabeaufforderung.- Bei Windows kann man "Eingabeaufforderung" in der Taskleiste suchen

- Unter Linux benötigen Sie ein Terminalfenster ("Str-Alt-T")

- Im MacOS können Sie "Terminal" in der Spotlight-Suche öffnen

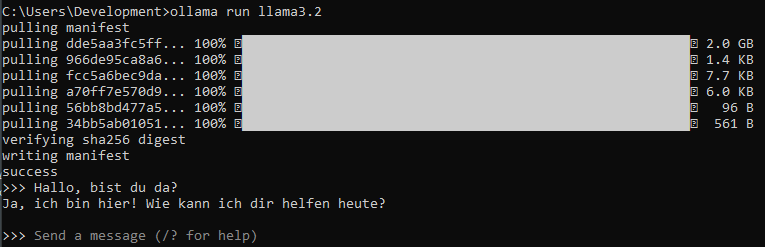

ollama run llama3.2 in der Eingabeaufforderung lässt sich das Open-Source Modell "llama3.2" von der Firma "Meta" herunterladen und ausführen oder installieren Sie mit ollama run deepseek-r1:7b eine Version des chinesischen Modells DeepSeek-R1 (7 Milliarden Paramter), welches Anfang 2025 für einige Aufregung sorgte.

Es sind auch zahlreiche andere Sprachmodelle verfügbar, wie z.B. die "mistral" Modelle von der französischen Firma mistral.ai. Die jeweilige Leistungfähigkeit der Modelle hängt von der aktuell veröffentlichten Produktversion ab. Mit Klick auf den Menüpunkt Models auf der Ollama Webseite (siehe Bild oben) lassen sich die aktuell verfügbaren Modelle anzeigen. Hier gelangen Sie auch zu Ergebnissen bei Vergleichstests.

Nach der Eingabe von ollama run llama3.2 sollte Ihr Fenster wie folgt aussehen, das Downloaden kann einen kleinen Moment dauern:

Sobald der Download abgeschlossen ist und "success" ausgegeben wird, lässt sich bereits mit dem Chatbot interagieren. Sie können nun Prompts eingeben, wie etwa in dem Beispiel: "Hallo, bist du da?", Ihr lokal installiertes LLM wird Ihnen antworten! Um den Chat zu beenden können Sie den Befehl

/bye ausführen, so gelangen Sie wieder in Ihrer normalen Konsole. Wenn Sie sich wieder außerhalb des Chats befinden (erkennbar dadurch, dass keine ">>>" mehr am Anfang Ihrer Zeile zu sehen sind), lassen sich mit dem Befehl ollama list die aktuell installierten Sprachmodelle anzeigen.

Eine Übersicht zu den verfügbaren Kommandos erhalten Sie durch Eingabe von ollama (ohne weitere Zusätze). Dies kann auch als Test genutzt werden, ob die Installation geklappt hat, denn sonst ist der Befehl nicht verfügbar.Schritt 3: Eine Benutzer-Oberfläche einrichten

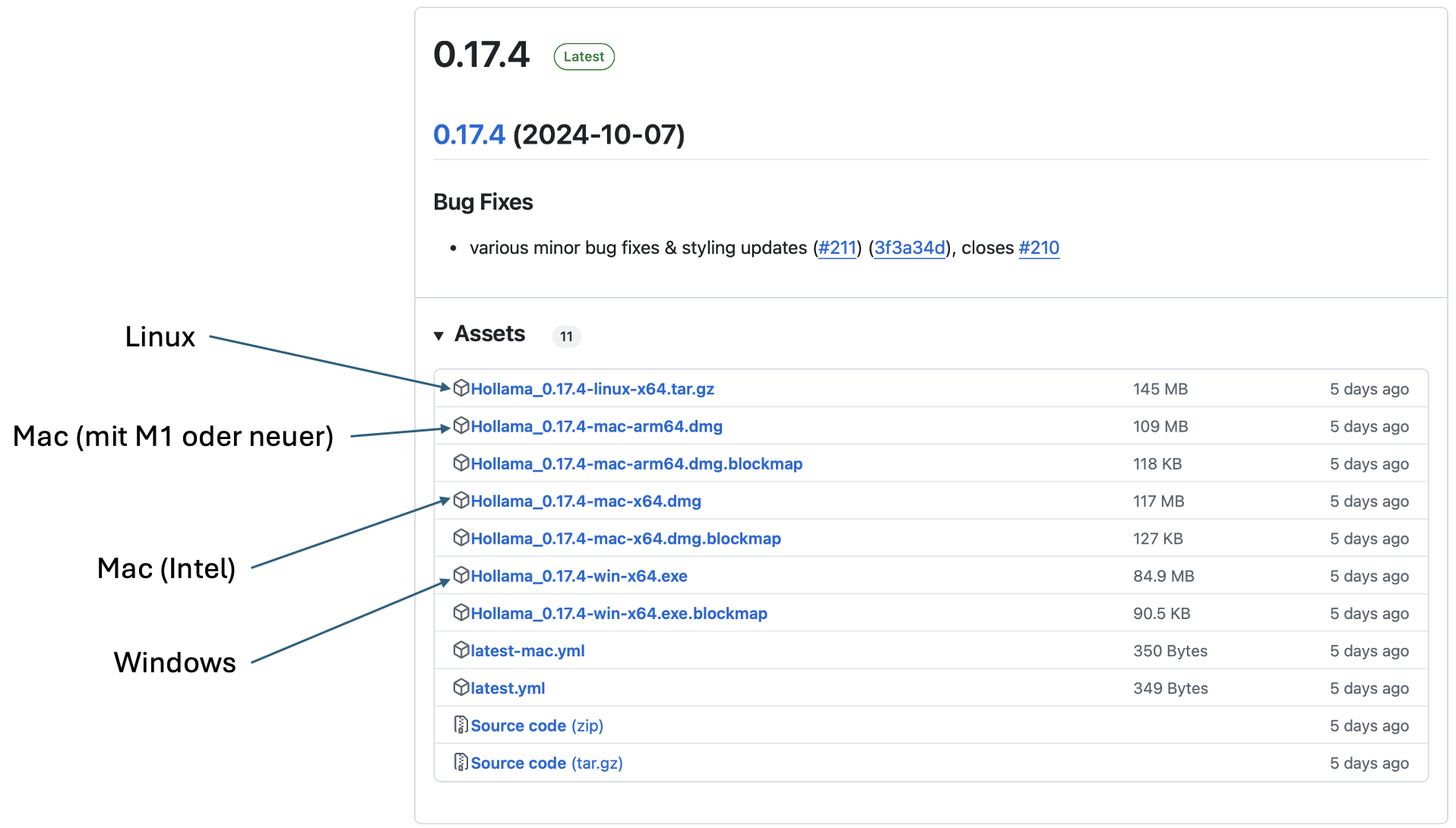

Man kann sich für Ollama auch eine Oberfläche installieren, die im Browser ein Erscheinungsbild erzeugt, wie man es vielleicht von ChatGPT & Co gewohnt ist. Gerne könne Sie dazu recherchieren. Sie finden auch eine Auflistung auf der GitHub Seite unter dem Abschnitt "Web & Desktop". Eine Möglichkeit ist z.B. die Oberfläche "Hollama". Auf der Seite https://github.com/fmaclen/hollama lässt sich unter:- 🖥️ Download for macOS, Windows & Linux

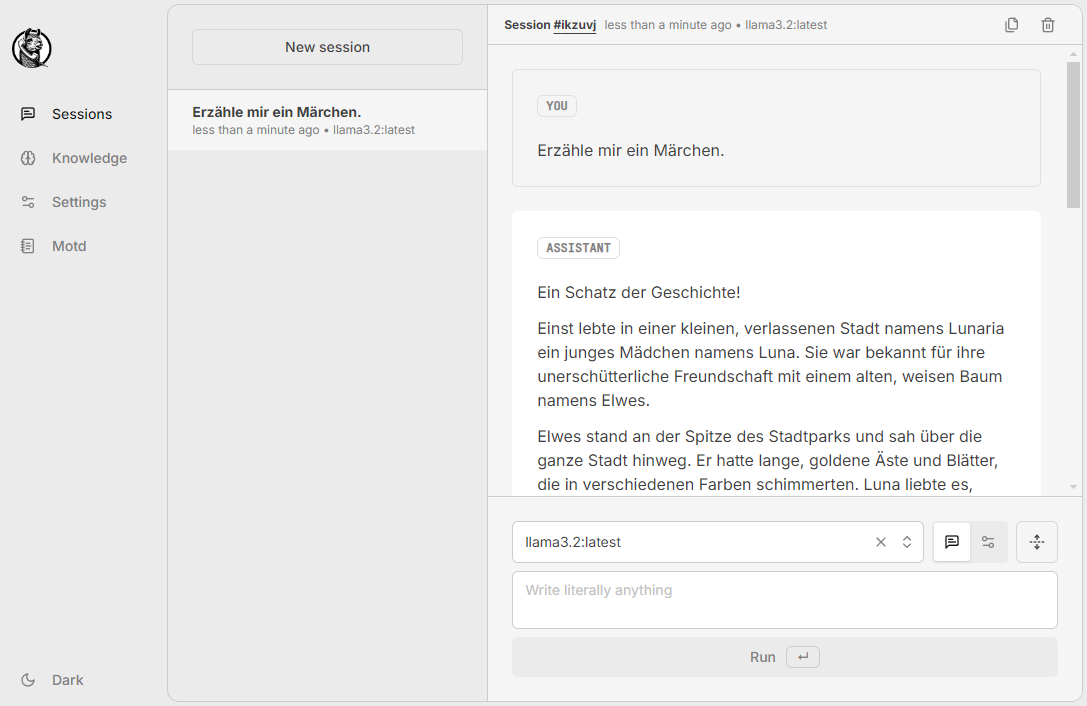

Das geladene Programm sieht dann so (oder ähnlich) aus:

Unter dem Reiter "Sessions" lassen sich Chats starten, ähnlich wie bei beispielsweise ChatGPT.

Eine weitere Benutzeroberfläche, unter anderem für Ollama, bietet die Software "Open WebUI". Auch hier können lokale Dokumente in einem geschützten Bereich hinzugefügt werden und vieles mehr. Wenn Sie sich für die vielfältigen aktuellen Möglichkeiten im Zusammenhang mit lokalen KI-Modellen interessieren, möchten wir Sie an dieser Stelle ermutigen, selbst ein wenig zu recherchieren.

Sicherlich gibt es noch weitere Möglichkeiten. In jedem Fall wünschen wir viel Erfolg bei der Einrichtung des eigenen Chatbots!

Euer

digi4all-Team