Transparenz und Erklärbarkeit

In unserer Simulation hatten wir ein sehr einfaches Künstliches Neuronales Netzwerk mit einer simplen Architektur, nur wenigen Eingaben und wenigen versteckten Schichten. Doch in realen Anwendungen sieht das oft ganz anders aus: Dort kommen tiefe neuronale Netzwerke zum Einsatz, die mit riesigen Datensätzen trainiert werden und deutlich komplexere Architekturen aufweisen – mit sehr vielen Eingaben und zahlreichen versteckten Schichten und Gewichten (auch Parameter genannt).

Diese trainierten Modelle sind sehr undurchsichtig und werden dann oft als „Black-Box-Modelle“ bezeichnet. Black-Box-Modelle sind von Natur aus komplex und bieten keine Erklärungen für den Entscheidungsprozess (d. h., es ist für Nutzende – manchmal sogar für die eigenen Entwickler und Entwicklerinnen – nicht möglich zu verstehen, wie und warum die KI-Systeme ihre Ergebnisse liefern).

Viele der fortschrittlichsten maschinellen Lernmodelle, die heute verfügbar sind, einschließlich großer Sprachmodelle wie OpenAI’s ChatGPT und Meta’s Llama, sind Black-Box-Modelle.

Warum sind Black-Box-Modelle ein Problem?

KI-Modelle können falsche Schlüsse ziehen. Bei Black-Box-Modellen, die in äußerst sensiblen Bereichen wie der Strafjustiz (z. B. bei Rückfallprognosen) oder der Polizeiarbeit (z. B. bei Gesichtserkennung) eingesetzt werden, ergeben sich jedoch noch zusätzliche Bedenken.

1. Ein Beispiel: Ein hypothetisches Black-Box-KI-Modell könnte Vorhersagen darüber treffen, ob ein Patient oder eine Patientin an einer lebensbedrohlichen Krankheit wie COVID-19 leidet. Wenn das Modell etwa prognostiziert, dass bestimmte Personen nicht erkrankt sind, und sich medizinisches Personal auf diese Einschätzung verlässt und keine Behandlung einleitet, kann dies schwerwiegende Konsequenzen für die Betroffenen haben. Im Nachhinein müssen Ärztinnen und Ärzte ihre Entscheidungen möglicherweise rechtfertigen – was problematisch ist, wenn sie sich auf ein KI-Modell verlassen haben, dessen Entscheidungsgrundlagen nicht transparent oder erklärbar sind.

2. Ein weiteres Beispiel ist der Fall, wenn ein autonomes Fahrzeug einen Fußgänger oder eine Fußgängerin erfasst, obwohl man erwartet hätte, dass es rechtzeitig bremst. Aufgrund der Black-Box-Natur des KI-Systems lässt sich der Entscheidungsprozess nicht nachvollziehen – wir wissen also nicht, warum das Fahrzeug so gehandelt hat. Dieses Fehlen von Erklärbarkeit erschwert es außerdem, das System gezielt zu korrigieren, wenn es zu unerwünschten oder gefährlichen Entscheidungen kommt.

Ein reales Beispiel:

Die US-amerikanische National Highway Traffic Safety Administration (NHTSA) hat eine Untersuchung zu 2,4 Millionen Tesla-Fahrzeugen mit Full Self-Driving (FSD)-Software eingeleitet, nachdem vier Unfälle unter schlechten Sichtverhältnissen gemeldet wurden, darunter ein tödlicher Fußgängerunfall. Die Untersuchung umfasst Tesla-Modelle der Baujahre 2016 bis 2024 und prüft, ob das FSD-System reduzierte Sichtverhältnisse effektiv erkennt und darauf reagiert.

In solchen Fällen wäre es angemessen, wenn das KI-System eine Rechtfertigung für seine Ergebnisse liefert, damit Nutzende Vertrauen in die Systeme aufbauen können. Black-Box-Modelle verringern das Vertrauen der Nutzenden in KI-Systeme und reduzieren folglich deren Akzeptanz.

Welche möglichen Lösungen gibt es, um das Vertrauensproblem der KI-Nutzenden zu lösen?

Es gibt verschiedene Lösungsansätze:

- Obwohl tiefe neuronale Netzwerke beeindruckende Ergebnisse liefern, ist es für bestimmte Probleme möglich, sogenannte „White-Box“-Modelle wie Entscheidungsbäume oder lineare Regression (siehe Modul 05) zu verwenden. Besonders in hochsensiblen Bereichen wie Medizin, Finanzen und Kriminalitätsrisikoanalysen ist es vorzuziehen, „White-Box“-Modelle einzusetzen, wenn dies möglich ist.

- Eine weitere Alternative besteht darin, erklärbare KI-Methoden (Explainable AI, XAI) während des Modelltrainings anzuwenden. Explainable AI ist ein aufstrebendes Teilgebiet der KI, das Werkzeuge und Techniken entwickelt, um Black-Box-KI-Lösungen verständlich, transparent und nachvollziehbar zu machen.

- Außerdem wäre es vorteilhaft, wenn die Entwickelnden von KI-Systemen transparenter sind und Informationen darüber bereitstellen, wie das System entwickelt, trainiert, betrieben und in seinem Anwendungsbereich implementiert wurde. Dadurch können Nutzende fundiertere Entscheidungen über die Verwendung oder Ablehnung des Systems treffen.

Transparenz bedeutet, dass Menschen nachvollziehen können, wie ein KI-System entwickelt, trainiert, betrieben und in einem bestimmten Anwendungsbereich eingesetzt wird – etwa damit Verbraucherinnen und Verbraucher fundiertere Entscheidungen über eine mögliche Nutzung treffen können.

Erklärbarkeit hingegen bezieht sich darauf, dass die Betroffenen die Möglichkeit haben zu verstehen, wie genau ein konkretes Ergebnis oder eine Entscheidung des KI-Systems zustande gekommen ist.

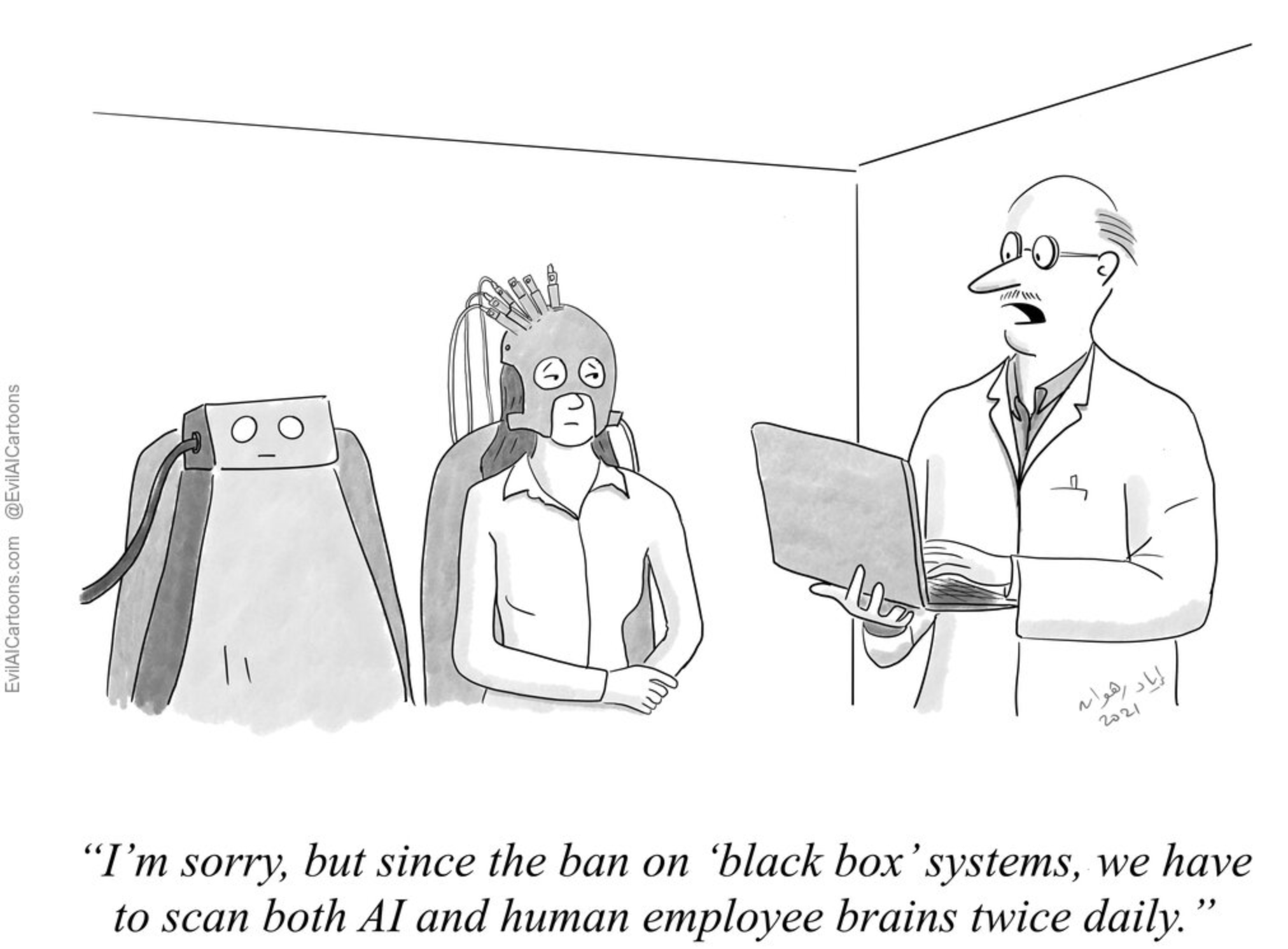

Ein bisschen Humor

"Es tut mir leid, aber seit dem Verbot von „Black-Box“-Systemen müssen wir sowohl die Gehirne der KI als auch die der menschlichen Mitarbeitenden zweimal täglich scannen."

Evilaicartoons. Terminology: Black Box. Online verfügbar unter: https://www.evilaicartoons.com/archive/terminology-black-box (letzter Zugriff: 15. Dezember 2024).

! Was ist Ihre Meinung zur Nutzung von KI-Systemen auf Basis von Black-Box-Modellen in sensiblen Bereichen wie Strafjustiz, Gesundheit, Bildung oder Polizeiarbeit? Sollte deren Einsatz verboten sein, nur unter Einhaltung bestimmter Transparenzregeln oder ohne Einschränkungen erlaubt werden? Wenn Sie der Meinung sind, dass Transparenzanforderungen für KI-Systeme in sensiblen Bereichen vorgeschrieben werden sollten, welche spezifischen Anforderungen halten Sie für notwendig?